こんにちは、株式会社インディバースの代表をしております河合大です。

私はRailsエンジニア x SEOコンサルタントということで、システム開発とSEOの両方を嗜んでいる人間です。

- 「インディバースフリーランス」という求人DBサイト

- 「アフィサーチ」というアフィリエイト案件検索サイト

を個人開発して運営しております。

さて、私自身もともとアフィリエイトメディア出身の人間でして、バックグラウンドはSEOコンサルではなく、記事型SEOでゴリゴリ組織を作っていくタイプのメディアをやってきていたのですが、

昨今の競合環境と(フリーランスエージェントのオウンド、DBサイト、あとサブディレクトリ)、Googleのコアアルゴリズムアップデートの影響で、「記事型サイト単体でやるのは限界なのでは?」と思うようになりました。

そこで、「エンジニアバッググラウンドもあるし、個人で完結するデータベース型SEOサイト、やってみたら面白いんじゃないか」と思い、データベースサイトの運営を始めました。

しかし、やってみていろいろと壁にぶち当たりました。

この記事を書くモチベーションとしては、こうです。

- テクニカルSEOについては、超良質な他社のサイトのおかげでググればそれなりの知識は手に入る。また周りに協業関係のあるDB SEOに強い知り合いが多かったので、行けそうだと判断。

- しかし実際にやってみたら、データベースサイトでのテクニカルな知識以上に、どちらかというと事業戦略/事業ドメインに関連するポジショニングや、営業/BizDev/法律/アライアンス/組織に対してのリソースがないと、伸ばせないことがわかった。

- Googleでそんなこと書いているデータベースSEOやテクニカル系のサイトの記事が見つからなかった

- なので、データベース型サイトをやろうと思っている会社があったら、先に知っておくと幸せになれるような記事を書きたいと思った。

初めから知っていれば、避けられた失敗も多々あるかと思います。そんなことについて書いていきたいと思います。

TL;DR

- データベースSEOサイトを導入することで、大きなメリットがある

- ただし、データベースSEOサイトでの成功は、「市場」が全て

- その市場で勝つための競合環境と、自社のリソースなどを加味した戦略を立てなければ、テクニカルSEOをどんなに頑張っても勝てない

免責事項

まず、この記事では以下のような知識は手に入らないです。

- データベースSEOメディアにおける、テクニカルSEOに関する知識。カテゴリ設計や、内部リンク設計, クロール最適化などの知識は、他の第一人者の代理店さんのメディアをみてもらった方がよいです。「データベースSEO 対策」などで調べるととても良い記事がたくさんでてきます。

どちらかというと

- データベース型メディアを新規で立ち上げようと検討している企業様や個人開発者様

にはお役立ちできるかと思います。

個人開発したデータベースサイトについて

私が個人開発したデータベースサイトについて、まず前提について書いていきたいと思います。

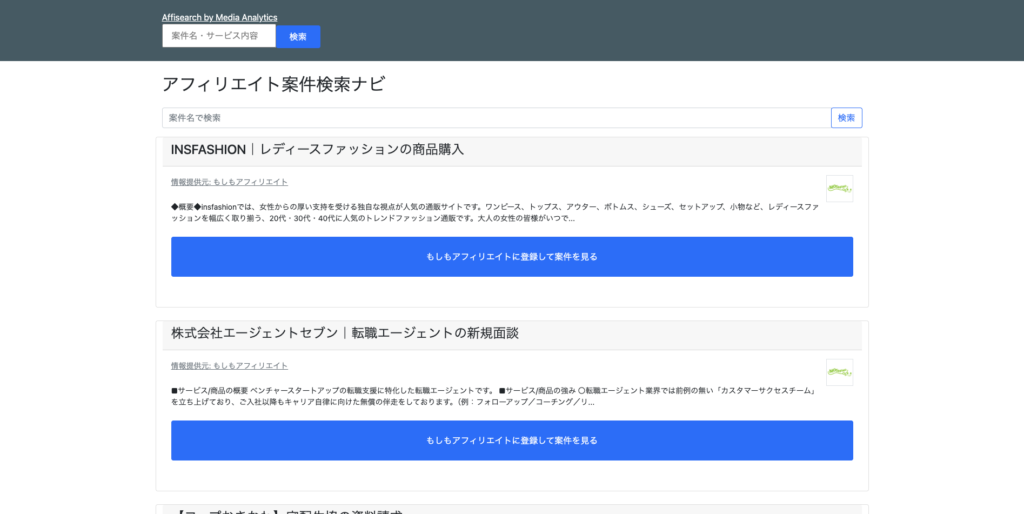

アフィサーチ

- サイトURL: https://media-analytics.jp/affisearch

- どんなサイトか:アフィリエイトの案件を抽出しDBに保存。だいたい1万件くらい。これを「$案件カテゴリ x アフィリエイト」のキーワードと、「$案件名 アフィリエイト」で掲載

- 収益モデル:ASPへの登録成果報酬(アフィリエイター / 広告主)

- ドメインの前提:もともと自社で開発しているアフィリエイトメディア向けデータベースSaaS「Media Analytics」のサブディレクトリに、nginxを経由してリバースプロキシしている。ほぼ外部対策を行なっていない都合上、ドメインランクは5。

アフィサーチは、「アフィリエイト案件を探しているアフィリエイター向けに、複数のASP案件を一括で整理しつつ、自分にあった案件が見つけられるサービス」となっています。

インディバースフリーランス

- サイトURL: https://freelance.indieverse.co.jp/

- どんなサイトか:フリーランスエージェントの案件のアグリゲーションメディア。複数のエージェントに登録し、案件を探す手間をなくし、一括で検索、登録ができるサービス

- 収益モデル:フリーランスエージェントの成果報酬

- ドメインの前提:もともと個人で運営していたDAINOTE(https://dividable.net)のコンテンツを、301リダイレクトを行い、弊社コーポレイトサイトのサブドメインへ移行した。(freelance.indieverse.co.jp) サブディレクトリにした理由は、このサイト(https://indieverse.co.jp)とのテーマ性を分けたい/co.jp ドメインでの運営を行いたかったため)ルートディレクトリに、Railsアプリケーションで、求人サイトを開発。

アフィサーチの企画 / 検証 / 売上 / 学びについて

さて、まずはアフィサーチについて開発した記録について書いていきたいと思います。

開発背景

だいたい1年前かな、第2子が生まれるタイミングで、妻の家に帰省していた時期に作りました。

もともと、自社開発しているSaaSサービスであるMedia Analytics( https://media-analytics.jp) というサイトのオウンドメディアで、 Media Analytics Blog(https://blog.media-analytics.jp)を運営していまして、主に自社のSaaSプロダクトの集客コンテンツを作っていました。

SEOアフィリエイターさんを多く獲得したいメディアだったので、ASPの比較記事とか、人気のASP案件がどこで提携できるか書いたら、集客につながるのではないかと思い、キーワードを見ていました。

その際、キーワードを見ていると、

- 「あれ、これめちゃくちゃアフィリエイト系のテールキーワードあるな」

- 「しかも競合にco.jpいないから弱いな」

- 「これ、DBで一括で書いたら、勝てるのでは?」

- 「アフィで売上出るし、自社のSaaSの集客できるし一石二鳥だな」

と気づきました。

そこで、1日くらいちょっと調べてみた結果、

- ASPの紹介単価は、だいたい300-1500円くらいのレンジなんだな

- 広告主獲得単価はだいたい1万円〜だな

- 競合サイトのDRでは、自社より高いところはあるが、滞在時間とかユーザーエンゲージメントみると低そうだな

- サイトテーマのカバレッジ埋めようとすると、多分コラムで書くよりも圧倒的にDBの方が有利そうだな

- 万が一個人ブロガーがテーマカバレッジ対応してこようと思っても、1万件以上コラムで書くと投資対効果合わないから、DBやってくるとこ以外は勝てなさそうだな

- すでに競合がやっているDB見ている感じ、やはりドメインが弱いので、勝てそうだ

ということがわかりました。

ということで、「ほんならDBサイトやってみたかったしやってみるか」と思って、1ヶ月くらいで開発して作ったサイトになります。

技術選定の話

まず、このサイトのゴールは「アフィリエイト案件が見つかること」となります。

そして、主な集客方法はSEOです。

この時点で、モノリスアーキテクチャのRailsで十分だなと思いました。

これは自社でMedia Analyticsというサービスを運営していて、CVR改善をひたすらやってきたからすぐに意思決定できました。

狙うクエリは、だいたい

- 「退職代行 アフィリエイト」 のような「$アフィリエイトカテゴリ x アフィリエイト」というキーワード

- 「リクルートエージェント アフィリエイト」 のような「$アフィリエイト案件名 アフィリエイト」というキーワード

この2つです。

そして、クエリは結果的には「どのASPに何の案件があればよいかわかる」だけで課題が解決するため、全部DOクエリになります。

このタイプのクエリはファーストビューに結論だけ書いてあれば、UXとしては成立するわけです。

となると、そんな実装のために、SPAにする必要もないです。枯れたRailsとHerokuで静的ページで出せばOK。

Redisも必要なく、DBももっとも安くよい。インフラ費用はだいたい1,000円くらいでいけそう、という算段がつきました。

ということはアフィ案件2件制約すれば元取れそうだな、ということで、やる意思決定をしました。

デザインに関しては、普通に個人ブログと同じような体裁でもよいし、ここにデザイン投資しても対してインパクトないな。ということで、レスポンシブにすらせずに出しています。

事業計画と売上の概算値

立ち上げ当初、だいたいの想定売上を出してみました。

まず、狙いたいキーワードは以下のとおりでした。

- $アフィリエイト案件カテゴリ x アフィリエイト(例:退職代行 アフィリエイト)

- $アフィリエイト案件名 x ASP (例:退職代行モームリ アフィリエイト)

- $ASP名 x 評判 (例: A8.net 評判)

それぞれのカテゴリ数に対して、平均PVをかけつつ、CVRは比較系クエリだと5%前後、単一プロモーションの場合2.5%と想定しました。

そして広告主, メディア獲得で、ほとんどがメディア登録になるので平均単価は1,000円程度という見積もりを出しました。

これに対して原価ですが、

- インフラ費用: 1,000円

- ドメインはサブディレクトリなので無料

- 人件費は個人開発なので無料

- 競合がそこまで記事型SEOで記事を書いてくることもなさそうなので、リライトやメンテナンスなどの費用はかからない

と見積もりました。

アフィリエイトの売上でMedia Analyticsの広告費分が出せればちょうど良いな、と思いました。

初期検証

とはいえ、開発にも最低1ヶ月はかかりそうですし、リリースしてから失敗するのも嫌なので、

「サブディレクトリではなく、まずはサブドメインのオウンドメディアで一回似たような記事出した時に初動がどうなるか見てみるか」

と思い、blog.media-analytics.jp に試しにコンテンツを入れてみました。

箇条書きで、「ここに案件があります」と書いただけの記事です。(多分5分くらいで書いた)

すると、さっそく6位になりました。

また、10日後にはCVも生まれました。

実装編

このサービスは、基本的に

- アフィリエイト案件検索

- アフィリエイトカテゴリ系の一覧ページの実装

- アフィリエイトカテゴリ系の詳細ページの実装

- その他SEO系施策(title, meta, 構造化データ)

- 案件データのクローリング実装

- 内部リンク設計

- 管理画面における、案件のカテゴリ設定

- 管理画面における、アイテムの編集, 削除, 閲覧機能

- サイトマップ, インデックス制御

- サブディレクトリに設定するためのnginxの設定

これで要件が全て完結するため、かなりミニマムな実装になっています。

基本的に工数がかかるところは、案件データのクローリングと、301リダイレクトのリバースプロキシでした。

まず、クローリングについては規約についてもろもろと確認しつつ、進めました。ほとんどのASPには特に何も書いていないので、そのまま実装を進めました。それぞれに対してクローラー書くのはそれぞれDOM構造が異なるのと、ASPが13個以上あったので、めちゃくちゃ面倒でした。

サブディレクトリへの301リダイレクトは、ルートのプロダクトに影響を与える(アプリケーションサーバーで新規でnginxを挟まないといけないので、プロダクトに影響が出る)可能性があったため、「儲かるそうならサブディレクトリに移す。それまではサブドメインで運用する」と意思決定しました。

サブドメインでのリリース

一通りクローラーが書き終わって、データベースも整理できたので、サブドメインへリリースしました。

その結果、1日後に初コンバージョン。翌日にまた1件のコンバージョン。

DBサイトはコラムサイトとはまた違った気持ちのよさがありますね。

「CV出るなら、次はサブディレクトリに移行するか」と思い、301リダイレクトを進めました。

サブディレクトリへのリダイレクト

media-analytics.jp のサブディレクトリに別アプリのRailsプロジェクトをリバースプロキシする実装が必要になりました。

運用しているHerokuでリバースプロキシ書こうとすると、nginx入れるとかになるんですが、Heroku自体buildpackの仕様がかなりしんどく、301リダイレクトのnginx書くのに一番時間がかかりました。

サブディレクトリでのリリース

サブドメインに301をかけて、サブディレクトリで再度リリース。

サブドメインからサブディレクトリに載せ替えたら、やはり売上がバコンと上がります。

だいたい一ヶ月で流入が10倍くらいになりました。

CVも5倍くらいになりました。

さらなるSEO強化 + 生成AI活用

さて、初期はASPから案件データをクローリングした案件をそのまま表示するだけの機能でリリースしていました。

その際、3つ課題がありました。

- アフィリエイトの案件名には案件名が含まれているものの、案件名以外の余計な文言が多く含まれていた

- アフィリエイト案件にそもそも案件が含まれていなかった

- カテゴリページの実装ができていなかった

一つ目は、例えば「今注目されている弁護士監修の退職代行【モームリ】」のような案件名の場合、これをアイテムページで「モームリ アフィリエイト」と対策したいとします。この場合、余計な文言が多く含まれているため、ぴったりのタイトルで指定することが難しいです。

とはいえ、1.5万件近いDBに対して、それぞれ対応していくのは相当工数を使います。一人の組織でやろうとすると限界です。

ここに関しては、「Open AI API GPT-4 mini」モデルを利用して、サービス名抽出スクリプトを書いて一斉置換しました。だいたい体感8割くらいはいい感じにサービス名を抽出してくれました。

次に、アフィリエイト案件にそもそも案件が含まれていないケースです。これは案件詳細に含まれていたりいなかったりします。

できればAIで全部解決したかったのですが、難しそうなのでここはいつもお世話になっているWeb系タスクに特化した就労移行支援B型の障害者雇用支援施設にご依頼しました。案件を一つ一つ見てもらって、サービスはどのカテゴリの案件なのか指定してもらう。これはかなり手間な作業なのですが、いつも提携してくださっているWells Tech さんにご依頼して進めました。※Web系のラストワンマイルのお仕事はマジでWells Techさんおすすめです(宣伝)

そして最後。カテゴリページの実装ができていませんでした。例えば、「モームリ」なら退職代行ですし、「リクルートエージェント」なら転職エージェントですね。このようなカテゴリ指定は、ASP上のデータだとアバウトすぎて検索キーワードとしては不向きです。

そのため、以下のようなアプローチを取りました。

- Open AI GPT-4 mini APIを利用して、サービス名からカテゴリを自動生成

- 管理画面から使えないカテゴリを全削除

- ある程度カテゴリができた上で、手動でさらにカテゴリ追加

- 最後は手作業でカテゴリと案件を紐づける

データベースSEOで生成AIが活用できるのは、この辺の「いったんアイディアをばーっと出す」あたりの施策ですね。精度としては70%くらいになるのが前提で使うとよいです。残り3割を人がやるくらいがちょうど良いです。

管理画面から使えないカテゴリを目視削除はかなり骨が折れますが、気合いです。大事なのは全部AIでやろうとしないこと。品質を担保するのが人間のお仕事です。

カテゴリの手動追加については、SEOアフィリエイト的な知識がもろに必要とされるため、社内のアフィリエイトメディア運営のディレクターに依頼しました。前半はかなりサクサク見つけられたのですが、後半につれて「もうみつからねぇ…死ぬ…」という声が聞こえてきました。(手伝ってくれたNさんマジでありがとうございます!!)

そして最後に、プロモーションとカテゴリの紐付けです。これも最後は手動です。WellsTechさんにご依頼しました。

1年間運営しての売上

毎月3-4万円くらいの売上なので、年間だと40万円くらいですね。非常に雀の涙のような金額です。

毎月60件くらいCVしていて、平均単価が1000円、承認率が60%前後です。

ただ、1年くらい放置で稼いでくれています。

キーワード関連でいうと、案件名アフィリエイト系のクエリとカテゴリページからのクエリで50%/50%くらいでCVが入っています。

あとたまに、アフィサーチ経由でMedia Analyticsの問い合わせがきたりします。これは当初の目的を達成できたので、良かったかもしれません。

改善余地について

リソースがあれば、もっとこの辺をやります。やってない理由もセットで。

- ユーザー回遊の強化:左サイドバーに検索フォームを入れたり、Elasticsearchを入れて検索の精度を上げたりします。お目当てのアフィリエイト案件がもっと見つかりやすい状態を作ります。これはやりたいけどやれていないやつです。(他の優先順位で)

- 単価の開示:CVRが上がりそうな施策です。でも規約とか全てのASPと話つけるのが面倒。また単価データも単純な金額のみではなく、パーセントだったり成果報酬もCVではなくクリック単価だったりで、システム上のデータの持ち方が面倒。最新の単価を維持するのも大変そう。毎月300万円くらい儲かりそうならやる意思決定をしますが、そこまではいかなさそうなのでやっていません。

- 広告主向けのリード獲得ページの強化:人材業界 広告主 ASP などのキーワードで掛け合わせの実装→おそらく単価がもっと上がります。が、リード数はそこまで多くないかも…。あと成果報酬出してない広告主も多く、交渉に時間かかりそう。(月間で0.5-1件は広告主登録あります。)アフィリエイト広告を運営しているビジネスマッチングサイトみたいなものをやると、もっと売上上がるかもしれませんがカロリー使うのでやっていません。

- ASPの一括登録機能を作成。複数のASPに登録することが想定されるので、全てのASPと話をつけて、一括登録連携ができるようにします。これはよくアグリゲーションメディアでやる施策ですが、これもBizDevにそれなりに工数をさかないといけないのでやりません。

- 広告主向けの訴求を追加:今はメディア向けの登録ページしかありません。ただしこれだと単価が恐ろしく低いので、月50万円を目指していくとなると、やはり広告主向けのCVを増やす必要があります。ただし、広告主獲得で成果を出すASPが少ないので、営業をしないといけません。が個人開発だとそこまでできないのでやりません。

- 自社でアフィリエイト広告運用をやる代理店立ち上げる:素直にこのビジネスモデルは一回試したけど向いていないし情熱が湧かないのでやめました。ごりっごりの営業組織を作る必要があります。あとASPさんと利害相反する可能性も高いので、やっていません。

インディバースフリーランスの企画 / 検証 / 売上 / 学びについて

さて、次にインディバースフリーランスについてです。

開発背景

2019年から運営していた個人ブログDAINOTE(https://dividable.net)ですが、2023年9月のコアアルゴリズムアップデートをピークに、徐々に売上が下がっていました。

当初はフリーランスエージェント領域に参入しておりましたが、コアアルゴリズムアップデートの結果、アフィリエイトサイトがいなくなり、企業オウンドかデータベース型サイト, あとは寄生サイトがメインに。

ユーザー行動 / サイトテーマのカバレッジなどを考えると、DBサイト化して対応したほうがいいのではないかと思うようになりました。

当初運営していたアフィリエイトメディアの課題

DBサイト前は、競合が書いた人材DBサイトの一覧ページを、人間が手動で書いてメンテナンスする仕組みでした。記事数としては1500記事近くあり、リライトの工数面において非常に課題がありました。

例えば求人データの更新オペレーションなどは、クローラーを回さず手動更新している以上、限界がありました。競合はここはマスタデータから自動で取得しているのにもかかわらず。

あと、テールキーワードは拡張すればするほど、記事のフレッシュネスの維持が難しく、原価構造を圧迫するので、伸ばすにも伸ばしきれないという課題がありました。

インディバースフリーランス立ち上げ時の課題

フリーランス求人サイトのDBを確率するためには、求人提供を合法的にOKをもらわないといけません。

一方で、個人開発なので、ここの営業/Bizリソースをどうするかが課題でした。

対応としては、すでにアフィリエイトで成果件数が多い広告主がいるASP様に、提携のご依頼をお願いしてなんとか求人提携してもらいました。(その節はご対応いただいたASPのみなさま、ありがとうございました)

プロトタイプ段階で、求人データはスクレイピングせず手動で入れて、「こういう感じで提携できませんか?スクレイピングするので!」という提案をしました。もちろん資料なども作りました。

送客実績があり、社内規定がまだそこまでガッツリ決まっているような企業でなければ、OKをいただけましたが、何も実績がない状態での提携は稟議がおりづらいことがわかりました。

技術選定

将来的には何度もstickyに利用してもらいたかったため、ユーザー登録や内部動線をインタラクティブにやろうと思ってReact x RailsでAPIモードでの実装を想定し、SPA構成で着手開始しました。

ただし、SEOの要件を考慮するとSPAで実装する際考慮事項が多かったり、単体テストの網羅が難しくなってきました。また、404エラーなどをフロントとバックを分けて書いていると、単体テストの量が増えたり、依存関係の修正が大変でした。

データーベースサイトは、とにかく以下要件が重要でした。

- 404や500番台をいかに無くすか

- SEO対策したHTMLタグが正しくレンダリングされるか

- 上を実現するために、テストのメンテナンスが楽か

UX要件よりも、エラーが少ない方を優先したかったので、8割React x Rails APIの構成で完成したタイミングで、生成AIが台頭してきたのもあり、フルRailsにリプレイスしました。

SEO強化

キーワードとしては、

- [職種 / スキル ] x フリーランス / 業務委託 / 派遣

- [フリーランスエージェント] x 評判

- [フリーランスエージェント] x マージン

を狙っています。

[職種] と [スキル]の辞書データをどれだけ増やせるかと、それに該当する求人データを増やして、価値のあるページをどうやって作るか。が重要になってきます。辞書データ穴掘れわんわん作戦です。

[職種], [スキル] に関しては、以下のアプローチを使いました。

- 競合のカテゴリ階層から、眼に見える範囲のカテゴリをとってくる

- robots.txtからsitemapへアクセスし、カテゴリ関連のデータをとってくる

- 求人データを連結して、Mecabにぶっ込んで形態素解析して固有名詞をとってくる

robots.txtからsitemapへアクセスしようとしましたが、日本のトップSEOメディアはrobots.txtを隠蔽しているため、カテゴリやスキルの一覧データは取得できませんでした。(ちなみに最大手は隠していましたが、3番目くらいのメディアは公開していました。こういう細部に神は宿るのだな、と思いました。)

ページ階層さえルールがあれば、そのページ階層でAhrefsでとってくるという技も使えるのですが、その場合は月間vol.がある程度ないとボリューム自体が表示されません。そのため、可能な限り該当する職種, スキルページを取得するというものは、このアプローチだと厳しかったです。

別のアプローチで、クロールした求人データのテキストデータをjoinして、Mecabにぶちこんで形態素解析した結果を出す、というアプローチを使いました。そしてこれに対して全部小文字化して正規化し、ユニークを削除するという方法を使いましたが、これはかなり穴掘れわんわんに成功しました。

次に、フリーランスエージェントの評判やマージンなどですが、これは一般的にコラム型ページの方が自由度が高いため、評判系記事はDB要素を入れつつ、あとは動的生成で戦う戦略を選びました。

フリーランスエージェントの評判については、クラウドワークスとランサーズ、Xから3000円で口コミを25件ほど集めました。その中に対策したいキーワード(例えばマージンなどに)関する質問を入れておき、その結果をデータベースに保存します。※余談ですが、クラウドソーシングで生成AIで作成した口コミを納品してくる方もいたため、途中から実務経験や過去の発注などの要素も注意深くしっかりみた上で、選定しました。

あとは、フリーランスエージェントは業界的に基本はマージン非開示のため、「基本はマージン非開示だよ」というテンプレートファイルを入れつつ、「実際に利用した人の口コミをみてみてね」というUIにして、そこに口コミデータを動的に表示する、といった実装にしています。

実際の結果

一部ブログではとりきれなかったテールキーワードからのコンバージョンが増えました。

月に4-5件新規でDB経由から申し込みが入ります。成果保報酬が全承認で2万円くらいなので、月8-10万円くらいのインパクトになります。

また、自社のアグリゲーションメディアからのCVはマッチングの質がよく、承認率が増えました。

人材系なので1件の成約のインパクトが大きいので、投資してよかったなと感じました。

ただし、競合のDBサイトほど上位表示できるわけではなく、これを行うことによって劇的に売上が増えたわけではありません。

改善余地について

- より細かなカテゴリの追加。

- より細かな掛け合わせページの追加。

- SES業者と直接求人提携。一括申し込みなどでより多くの送客を実現できそうですが、アライアンスに一定の工数を割く必要がありそうなので、やれていません。

- ユーザー登録動線の強化。登録数を増やして、新着案件をメールで配信するなどしたいのですが、基本的にはユーザー登録なしで送客するアフィリエイトの延長のため、ユーザー登録させるインセンティブがありません。事業構造をドラスティックに変える意思決定をしない限りはやれないです。

- SESへの営業。求人データを提供してくれるSES会社に対して営業を行います。これも個人開発のみで売上を上げるという制約上やっていません。

- ブログサイトから自社アグリゲーションメディアの動線強化。ユーザーのマッチングの質の向上が見込まれ、さらにユーザー行動も強化されるためSEOにプラス。ただしアグリゲーションメディアに求人を出せる企業が少ないため、やりたくてもできない

※ご興味ある企業様いらっしゃいましたらお問い合わせくださいw

データーベース型サイトを2つ立ち上げての学び

大きく作る前に小さく検証は大正解だった

いきなりデータベースサイト作ると普通は3月は最低でもかかります。僕個人でPM, デザイン, フロントエンド、バックエンド、マーケをやっているのですが、普通の会社に頼んだら予算的にも500万円以上はすると思います。

こういう大きめなシステムに関しては、出してこけるくらいなら、先に自社オウンドメディアで小さく検証などが良いと思います。

CV取れるかどうかについても検証必要なので、DBサイトをやる前に、DBで入れたい記事を10個くらい手動で入れてみて、リスティング広告とかで検証しておくとなおよしです。

検索ボリュームツールでは、見えないキーワードが拾える。塵も積もれば山となる。

記事型メディアだと、検索ボリュームが少なすぎて網羅できないクエリがたくさんあります。

こういうクエリは、Ahrefsで見るとキーワードボリュームゼロになります。

一方で、データベースサイトのように、小規模のアイテムが10,000くらいになると、ちりつもで流入がめちゃくちゃ増えます。

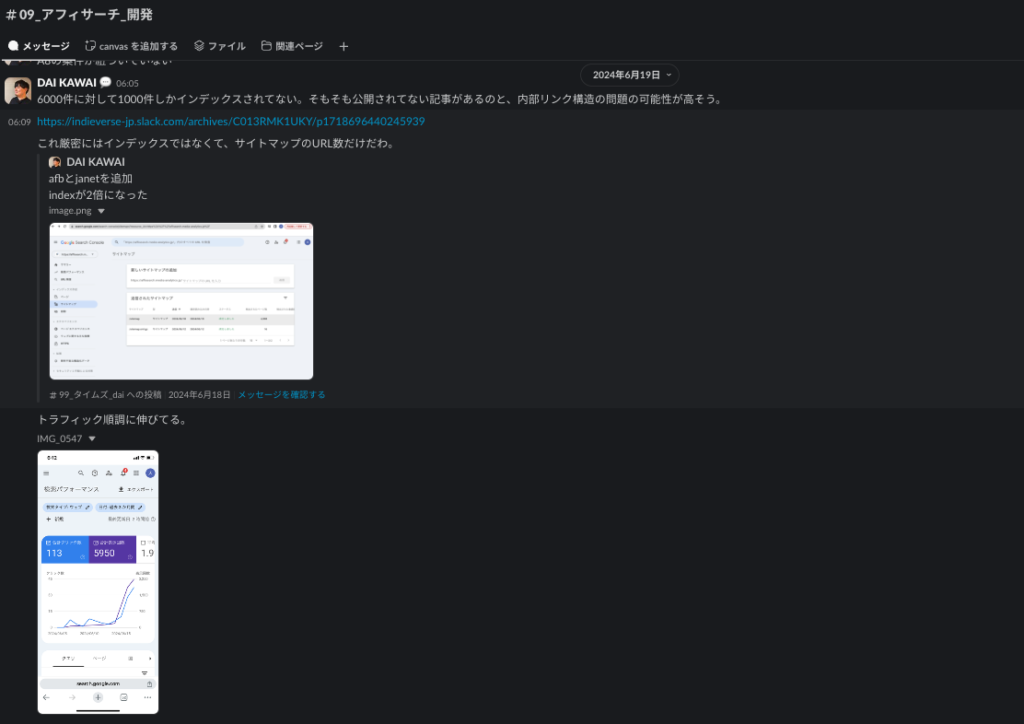

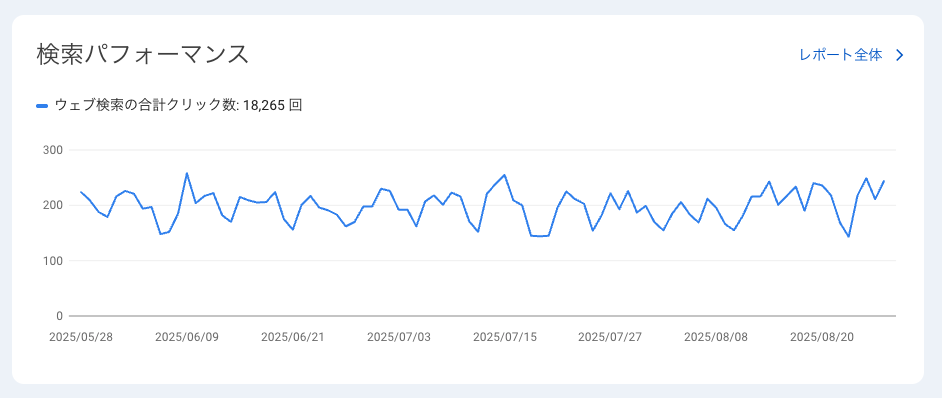

実際Ahrefsでは月間1100PVくらいしかない流入に見えても、サーチコンソール経由では毎日200クリックくらい出ているので、月間で60000クリックくらいはあります。

DBサイトとコラムサイトの両取りは強い

サイトテーマを上げるためには、ロングテールでの流入を獲得する必要があります。

しかし、コラム型サイトで大量に記事型コンテンツ作ると、メンテナンスするリライト原価が重くなります。特にテール型で作ると、

- 損益分岐点を超えられない

- リライトの原価が積もる

- メンテナンスされないのでサイト全体のフレッシュネスが落ちる

といったデメリットがあります。

ただ、サイトテーマをより強くしていくためには、関連キーワードでの流入を増やさないといけない。

そういう時に、データベースメディアとコラムを掛け合わせられるととても強いです。

逆もまた然りです。DBサイトでは、アグリゲーションするデータの量によって、SEOに得意・不得意が出てきます。

例えば、絶対に獲得したいキーワードが、アグリゲーションで上がりづらいクエリ意図だったり、自社の資産としてDBで上げきれないというケースもありえます。

そういう時は、逆にDBと並行してコラムを入れて、両取りしていくのがおすすめです。

キーワードカニバリゼーションを気になさるケースもあるかもしれませんが、オウンドのコラムとDBは、僕の感覚だと、ページの評価手法(品質評価ガイドラインだとPQ評価)が異なるように感じます。実際品質評価ガイドラインでも、ツールとコラムでは評価が異なると記載されています。なので、DBで伸ばし切ったらオウンド、オウンドで伸ばし切ったらDBという組み合わせが良いかなと思います。

DBサイトは楽しい

これは純粋に学びというわけではないのですが、DBサイトは自社のデータとキーワードの掛け合わせでかなり実験できます。

例えば、「ここって普通記事型で書くコンテンツだよね」というクエリに対して、「自社データを組み合わせてクエリの結果に答えられるコンテンツを作れないか」といろいろ実験することができます。

アフィリエイトサイトが狙う様な、「評判系キーワード」で、DB的にアグリゲーションして出し分けたコンテンツを実験がてら作ってみましたが、ちゃんと上位表示されました。(今は5位かな?)

自社のアセットをうまく有効活用しつつ、まだDBが入り切っていないけど、DBの結果の方が検索意図に答えられるよね、という余地があるので、この辺は面白いです。

データベースSEOは対象とする市場が全て

今回はこれがいちばん言いたいです。

SEOに限らず、マーケ、ひいては事業に関しては、対象とする市場が全てです。

例えば、アフィサーチに関しては、「ただアフィリエイト案件がどのASPにあるか調査できるツール」なのに1位を量産できました。ページも正直かなり低品質です。

これは別にデータベースSEOの知識があったからではなく、純粋に「競合とのポジショニングで勝てているから」です。

つまり競合は手動で書こうと思えば原価構造的に無理だし、DBサイトとしては法人でDBやっている会社があまりなかった。

売上としても小さいので大きい会社なら投資対効果が見込めない。

だからこそ、個人開発者でも勝てたんだと思います。

一方でインディバースフリーランスにおいては、そもそもフリーランスエージェントには上場企業が多数ありますし、未上場でも上場しようと思えばできるような企業がゴロゴロいます。さらに日本トップクラスのSEOの専門家、エンジニア、営業部隊がいるチームで戦うことになります。これを個人開発者で戦うのはさすがに限界があるな、と思います。

前述しましたが、例えば求人提携のアライアンスなどは、もっとリソースあればBizチームおいてやれるし、例えばアフィリエイトではなく直接送客の提携などを行えれば、もっとLTVを上げられるので、広告投資とかもできますし、ダイレクトリクルーティングなどもできると思います。

データベースSEOで勝つために乗り越えないといけない壁がたくさんある。

テクニカルSEO対策については、後で専門家を入れればどうにでもなりますが、競合・自社・顧客に関わる事業ドメインや事業モデルについてはどうにもなりません。

- ドメインの壁

- データ量の壁

- 組織の壁

- 提携・法律の壁

- ビジネスモデルの壁

ドメインの壁

データベース型サイトとして、高品質な被リンクを、継続的に獲得できる仕組みはあるか。

例えば、求人データ動向を毎月調査レポート出すみたいなPR施策をやる場合、そもそもの求人量と求人の質によって実行可能性が左右されます。

となると、結局ドメインの壁はアライアンスの強さなどに影響を受ける。これを初期の段階で明確に解決できるイメージできるか。またそれを実現するためのカネ・ヒト・モノのリソースを調達できるかが重要です。

また、アグリゲーションメディアの場合は自然な被リンクがどうしても自社でプロダクトを持っている会社よりも得られづらいです。その場合中間メディアとしてのプロダクトの価値をどうやって担保するかが重要になります。

データ量の壁

結局データベースSEOはデータ量だと思っています。

- ヒットLPを増やすために、カテゴリやアイテム数を増やす

- 内部リンク対策、ページ内回遊を促す

上はデータベースSEOでやる施策ですが、結局これに依存するのはデータ量です。なぜならデータが少なければ、データ数が少ない低品質ページが多くなってしまい、結局勝つことができません。

となると結局データベースの量が一番の付加価値になリます。

となると、データベースSEO型サイトのセンターピンはエンジニアではなく、結局事業開発側のアライアンスや営業がセンターピンになりがち。

逆に言うと、事業開発者や営業がデータを持ってきてくれないと、いくらテクニカルなSEOをやっても成果が出ない。

なので、戦略的にしっかりとデータ量が確保できるか?という観点が非常に重要だと思っています。(Cominkaの西奥さんと、謎のSEOマスターねこねこさんとの会話がとっても学びになりました)

組織の壁

前述した「データ量の壁」、「ドメインの壁」を解決するためには、結局はヒト・モノ・カネに対する投資がある程度必要です。

例えば連携を行う事業開発人材が必要になります。システム開発だけでグロースできるモデルではありません。

今回の場合弊社は代理店に依頼していますが、やはり成果報酬型アフィリエイトとして代理店に依頼すると、代理店側のメリットが作りにくいです。(確実にコンバージョンが増える確証がないまま、前例のない交渉を依頼しないといけない)

データベースSEO型メディアをやる場合は、こういうデータ量とドメインの壁を解決するための人材戦略も事前に考えておく必要があります。

ビジネスモデルの壁

ビジネスモデルも強く影響します。

たとえば、当社は純粋なASPを経由したアフィリエイトモデルですが、例えば直接送客機能を実装できれば、許容CPAをあげられるため、有料広告などももっと検討可能です。競合はこういうビジネスモデルをとっているため、例えばリスティング広告を強く打つことができますし、それによってアクセス数や指名検索を伸ばすことも可能です。それこそアフィリエイト広告を出稿することも可能ですね。

ビジネスモデルによって、打てる打ち手も制限されたり、逆に増やしたりすることができます。

データベースSEOをやるなら、アグリゲーションか自社データ活用かどっちが良いか

さて、データベースSEOサイトをやる場合、アグリゲーション(他社のデータを持ってくるタイプ)と、自社データ活用のどちらが良いでしょうか。自社でアグリゲーションをやってみて感じたことについてまとめます。

どちらかから始めて、徐々に複合型になっていくが良いと思います。

アグリゲーションメディアの強みと弱み

- アグリゲーションの強み:

- 複数サイトのデータを連携できるため、求人/商品などのアイテム数を増やしやすい。その結果サイトテーマのカバレッジを大きくしやすい

- アグリゲージョンの弱み:

- コンバージョンの最終地点ではないため、ユーザーのエンゲージメント的に弱い

- 「おすすめ」系のクエリで掲載されづらいので、サイテーションが稼ぎづらい

- 上記の理由からLLMO的にも、推薦されづらい(おそらくリンクのつき方的にも)

- アグリゲーションメディアの勝ち方:

- アライアンスやりきって、データ量を増やす

- ビジネスモデルでは外部送客は行いつつ、同時に自社プラットフォーム内で送客以外のキャッシュポイントを持ち、自社サービス化する(利害相反しない限りで)ことで、インバウンドなリンクを獲得できるように徐々にシフトしていく

- PR施策やアウトバウンドな外部リンク対策が必要

アグリゲーションメディアの場合、自社にアセットがない状態でもデータ量が貯められます。

そのため、BizDevが提携を頑張ればデータは集められます。

一方で、どうしても中間メディアになってしまいがちなので、インバウンドなリンクは獲得しづらいです。またそれはLLMによる推薦が行われづらいことを意味します。

例えばインディバースフリーランスに関しては、フリーランスエージェントではないため、「おすすめのフリーランスエージェント」みたいなキーワードでは掲載されづらいです。

そのため、中長期で自社サービスに滞在する何かしらのファンクションを再定義しつつ、送客メディアではなくてそのサイトがゴール地点になるようなビジネス開発が必要になります。

例えば、自社でフリーランスエージェントを行う、などです。ただしこの場合は送客先との利害相反が起こるため、例えばフリーランスエージェントがあえて捨てている「正社員で週1しか稼働量が稼げない人のセグメント」に対してリーチした、副業人材のダイレクトリクルーティングプラットフォームをやる、などが考えられます。他にも、ユーザー数を集めて、SES企業様向けの人材DBとしてプロダクトを再定義する、などもありえます。

アグリゲーションメディアとしての強みを活かしつつ、独自サービスへのシフトを行なっていくことで、両方を総取りできるような形ができると強そうです。

自社サービスの強みと弱み

- 自社サイトの強み

- コンバージョンの最終地点になり、滞在時間が長い→結果指名検索につながったり、行動指標が高くなる

- おすすめ系のクエリにのるので、サイテーションや被リンク獲得がしやすい

- 自社サイトの弱み

- アグリゲーションと比較して、データ量を稼ぎづらい

- 自社サイトの勝ち方

- 営業をやり切って、データ量を増やす

- 紹介されやすいようなUSPを構築する

- 自社データを利用したアグリゲーションメディアを別に立てる

イメージとしては、フリーランスエージェントをそのままやって、自社DBのデータをDBサイトにする感じですね。

この場合のメリットは、やはりこのサービスが終着点になるため、サイテーション獲得、指名検索獲得がしやすいです。ただし、データ量をどうやって確保するか、という観点が必要になってきます。そのため、すでにデータベースのアセットが十分にあるような企業様であれば、むしろここから始めた方が良いでしょう。

データベース型SEOサイトの施策強化は、テクニカル単体では成果が出せない

私のサイトのデータベース型SEOサイトは、もっとテクニカル的な観点での施策強化も本当はできるかと思います。例えばもっと掛け合わせキーワードのページ作って、インデックス数増やしたり、内部リンク増やしてページ内回遊増やそうぜ!みたいなのは実際いろいろできそうです。

ですが、自分の体感上、「テクニカル施策単体での成果」はかなり小さいと感じています。

それよりももっと

- 求人数増やしましょう

- そのために営業しましょう / BizDev強化しましょう / 人雇いましょう / 投資の意思決定しましょう (それがムリならM&Aなどでリソース確保しましょう)

- LLMにも推薦されるような事業モデルにドラスティックに変えましょう

といった施策が根本的に効いてきます。

そしてそれがネックになることが多いです。

テクニカルSEOはもちろん大事ですが、センターピンはそこではないのでは、と感じました。

SEOの延長線上でデータベースSEO戦略を考えない

いままで記載した、データベースSEOの4つの壁ですが、これって実は「よりユーザーにとって付加価値の高いサービスにするにはどうしたらいいか?」を考え続けると、同じ結果になるんですよね。

逆に「テクニカルSEOで勝つためにはどうしたらいいか?」だけの視点だと、戦略に一貫性がなくなりますし、施策実装者単体だと、施策が重すぎて気軽に提案できません。

そう考えると、データベースSEO施策は経営マターなのではないかというふうに感じます。

大きな意思決定が必要なため、役員レベルでのコンセンサスが必要だと思いますし、施策としてもかなり重くなります。副作用をもたらすようなリニューアルに近い実装をしないといけない可能性もあります。一種の賭けみたいな施策でもあります。

大胆な意思決定が必要な施策です。

最後に

データベースSEOサイトを立ち上げた上で、学びになったことをまとめてみました。

ちなみに宣伝です。もしデータベースサイト構築やコンサルティングなどでご相談がありましたら、壁打ちからでOKです!

ぜひお話ししましょう!

代表(河合大)とお話してみませんか?

河合大

河合大はじめまして。インディバースの河合大です。

システム開発からマーケティングまで、「こんなことを実現したいんだけど、どうしたらいいかなぁ」と悩んでいませんか?

カジュアルな相談から、課題の整理も大丈夫です。まずはお気軽にご相談ください。